- 글을 쓰고 있는 이 시점, 달력은 이미 봄을 표시했지만 아직도 추위가 남아 있다. 이 글을 읽을 즈음엔 SSM 독자 여러분들은 따뜻한 햇살의 봄을 만끽하시길 바라본다. 제작국의 요청으로 좋은 음향 기술 이야기를 나눌 수 있게 기회를 주셔서 감사하고, 이렇게 처음 SSM 지면을 통해서 독자 여러분께 인사를 남겨본다. 필자가 몸담고 있는 여러 공연, 방송 등의 이야기 중에서 어떤 부분이 ‘요즘’의 이야기로 좋을까? 를 고민했던 차다. 그래서 최신 디지털 믹싱 콘솔들에 적극 반영되고 있는 Delay Compensator 이야기를 해볼까 한다.

1. 서론

최신 디지털 믹싱 콘솔들의 트렌드는 DSP 연산 기술의 향상이 제일 큰 부분을 차지하는 것 같다. DSP 채널의 운용 가능 숫자 증가, 높은 샘플 레이트의 운용, 오디오에 특화된 디지털 오디오 네트워크의 내장화, 플러그인의 내장화 등이 있다. 48KHz 기반에서 96KHz로 샘플 레이트를 올려 해상도를 높이고. 레이턴시를 역으로 줄이는 것을 꾀하고 있다. 특히 MILAN, DANTE/AES67 등의 음향 업계 범용의 디지털 오디오 프로토콜을 내장하고 이미 사용하고 있던 디지털 오디오 프로토콜의 운용 가능 통로를 넓혀가기도 한다.

특히 3rd party 장비를 통해야만 사용할 수 있던 아날로그 이큐, 컴프레서, 리미터가 내부 플러그인화되었다. 리버브, 딜레이 머신 등의 이팩터 머신들도 콘솔 내부의 DSP를 활용해 운용할 수 있도록 하고 있는 점이 특징적이다. 이런 다양한 프로세싱이 믹싱 콘솔 내부에서 이루어지면서 계통별 레이턴시의 차이를 야기하고 이런 부분의 보정을 위해 적극적으로 믹싱 콘솔 내부에 Delay Compensator가 내장되고 있다. 이번 편은 그 딜레이 보정기의 필요성, 사용법에 다루어 보겠다.

2. 본론

2-1. 위상에 대해

우리는 Delay Compensator를 이야기하기 전, 시간의 지연으로 인해 결과물이 문제가 생기는 이유를 먼저 설명하고자 한다.

기본적인 물리적인 부분을 살펴보자. 위상에 대한 이야기이다. 다들 충분히 잘 알고 있겠지만 기억을 환기시키는 차원에서 살펴보자.

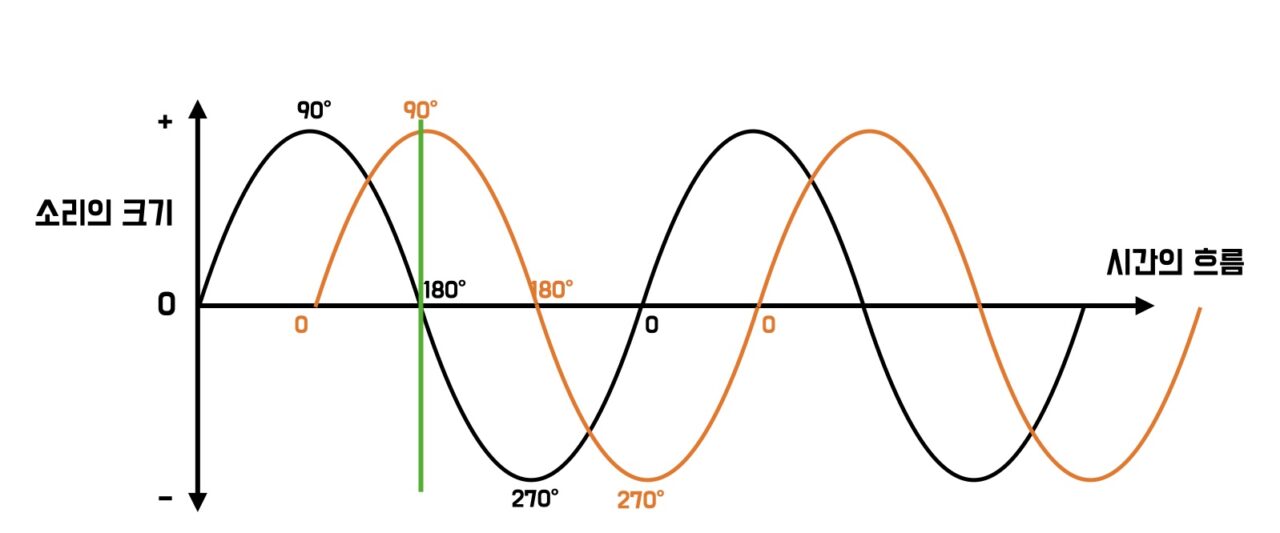

위상은 주기적으로 변화하는 파동이나 진동에서, 특정 시점에서의 파동 상태를 말한다. <그림 1>은 많이 보아왔던 그래프이다. 사인 함수 형태로 파형을 표시한다. 소리의 크기는 수직축, 시간의 흐름은 수평축으로 표현되어 있다. 수평축은 즉 시간축을 말하고 있으면서, ‘소리의 파동에서 특정 시점의 파동 상태’를 알 수 있는 위상도 함께 표현할 수 있다. 검정색 파형 기준으로 수직으로 그은 녹색선의 시점에 따라 검정색 파형의 위상은 180도의 상황이라 판단할 수 있다. 그래프의 수평축인 시간의 흐름과 위상의 변화는 비례해서 움직이고 있다. 추가로 주황색 파형까지 2개 파형이 있고, 수직으로 그은 녹색 선의 시점에서 각 파형의 시점(위상)을 본다면 주황색 파형은 90도의 위상을 가지고 있으며 검정색 파형과 비교하면 90도의 위상차를 가지고 있다. 두 파형을 시간의 시점에서 봤을 때, 출발점 내지 도착점의 시간차가 발생한다. ‘시간차’는 즉 ‘위상차’도 발생하는 것이라 확인할 수 있다.

만약 2개 파형이 한 시점에서 위상이 같다면 파형은 위상차가 없다고 표현하며, 두 파형이 합쳐졌을 때 정확하게 두 배의 소리가 된다. 만약 2개 파형이 한 시점에서 위상이 완벽하게 다르다면(180도 차이) 위상차가 최대가 되고, 합쳐졌을 때 정확하게 소리는 상쇄되어 사라지게 된다. XLR 회로의 원리나 라인 어레이 이론, 노이즈 캔슬링 등의 실제 사례에서 우리는 이 위상과 위상의 차이를 잘 이용하고 있다.

하나의 음원에서 소리가 시작되어 복수의 마이크에 집음되는 예를 보자. <그림 2>와 같이 하나의 음원이 두 마이크로 도착하는 시간이 동일하다면, 파장은 같은 시점의 위상을 갖게 되어 2배의 소리가 만들어지게 될 것이다. 마이크에 도착하는 두 음원 사이에 위상차가 없기 때문이다. 만약 <그림 3>과 같이 하나의 음원과 거리가 다른 마이크로 각각 집음하게 되면 거리차로 인해 도착하는 소리의 시간차가 발생하게 된다. 물론 위상의 차이를 만들게 되며, 이 상황에서 두 마이크를 동시에 확성하게 되면 <그림 2>의 상황과 달리 위상차로 인해 목표했던 결과물을 얻지 못할 가능성이 커진다. 즉 두 파형의 거리차가 발생, 시간차, 위상차가 발생하는 것과 같다는 것을 도출할 수 있다. 즉 ‘거리차 = 시간차 = 위상차’로 해석할 수 있다.

자, 복수 이상의 소리가 시간차, 위상차, 거리차가 발생하면 파형의 위상의 차이를 야기하고, 이는 소리의 결과물이 목표한 것과 다른 결과로 나온다는 이론적인 부분을 간단히 설명해 보았다. 이는 소리가 시작하는 시점 내지 도착 시점을 기준으로 이야기하는 순수 물리적인 부분의 해석이었다.

2-2. 레이턴시(Latency)에 대해

레이턴시란, 한 시스템 내에서 특정 작업이 시작되어 완료될 때까지 걸리는 지연 시간을 말한다. 이는 정보 기술, 컴퓨터 네트워킹, 통신 등 다양한 분야에서 사용되는 용어이며, 주로 데이터가 소스에서 목적지까지 전달되는데 소용되는 시간을 나타낸다. 우리의 오디오 분야에서 해석하자면 아날로그 형태의 음원이 우리가 사용하는 음향 시스템에 입력된 이후, 디지털 데이터로 변환되고 다시 결과물이 소리로 표현되는 데까지 걸린 시간으로 해석할 수 있다. 디지털 믹싱 콘솔의 입장에서 본다면, 아날로그 오디오의 입력/변환, 내부 연산, 오디오의 변환/출력까지의 시간을 디지털 믹싱 콘솔의 레이턴시로 볼 수 있다. 확성을 위한 전체 음향 시스템으로 본다면 입력 이후, 디지털 믹싱 콘솔의 연산, 출력 이후 외장 디지털 스피커 프로세서나 DSP 내장 앰프로 입력, 스피커의 확성까지 시간으로 간단히 생각할 수 있다.

디지털 믹싱 콘솔의 구성 요소 중, I/O는 아날로그 형태의 전기적 신호를 디지털 신호로 변환하는 ADC(아날로그-디지털 변환기), 디지털 신호를 아날로그 형태의 전기적 신호로 변환하는 DAC(디지털-아날로그 변환기)의 조합으로 설명할 수 있다. 모든 형태의 변환기들은 시간의 지연을 만든다. 즉 ADC, DAC는 시간 지연을 필수적으로 만든다.

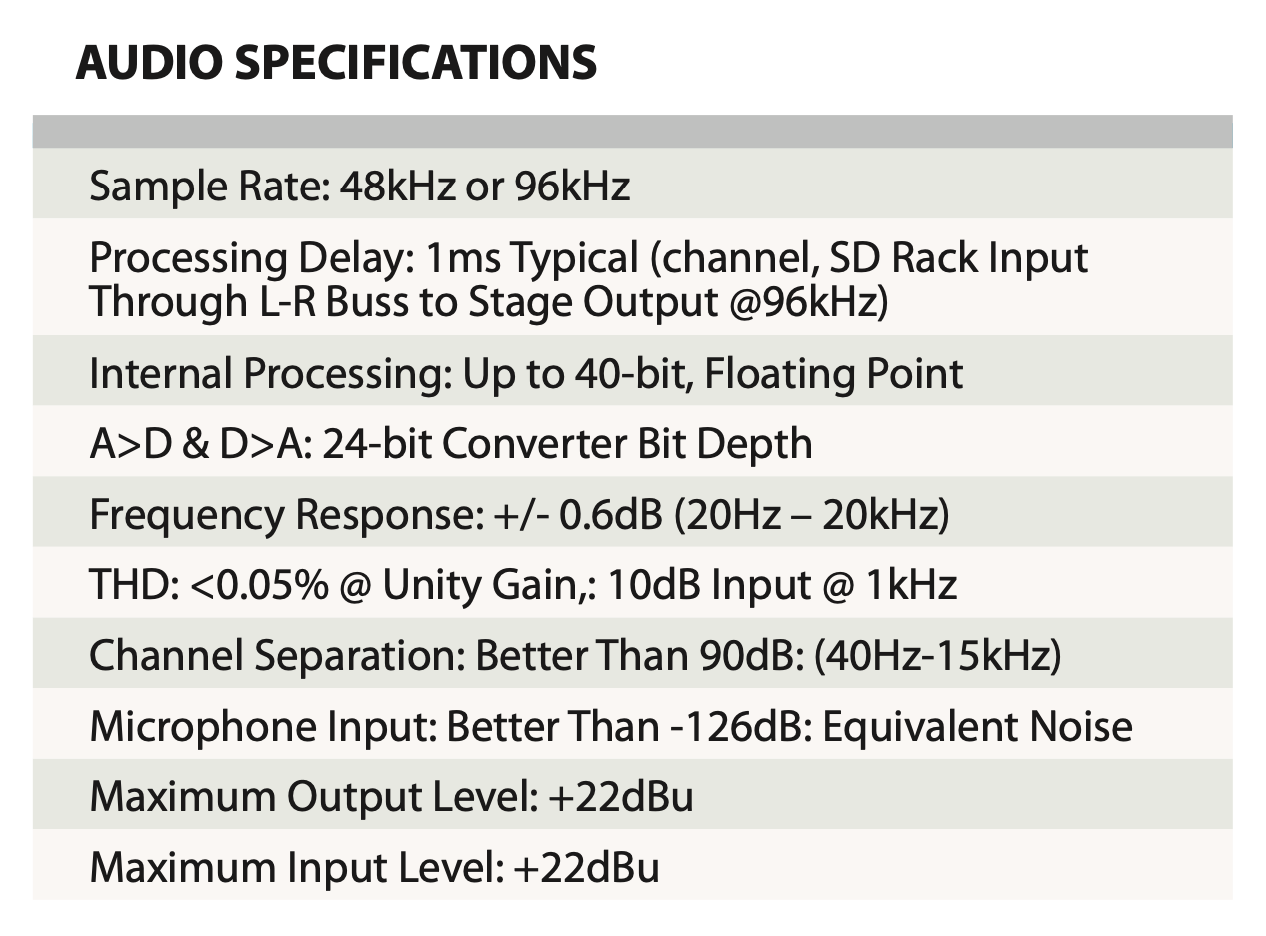

다른 디지털 믹싱 콘솔의 구성 요소인 디지털 데이터를 가공하는 DSP는 또 다른 시간의 지연을 만들어낸다. <그림 4> DIGICO SD12 스펙 시트의 내용 중 Processing Delay 파트가 In to Out의 레이턴시를 표현하고 있는 부분이다. SD-Rack의 인풋 포트를 통해 인풋 채널이 L-R 버스로 라우팅하고 SD-Rack 아웃 포트로 출력했을 때의 시간이 1ms 정도의 레이턴시를 가진다고 밝히고 있다. 대부분의 디지털 믹싱 콘솔은 이렇게 In to Out 레이턴시를 스펙 시트에 표현하고 있다.

디지털 믹싱 콘솔을 구성 요소 중 시스템 하드웨어를 구성하고 있는 외부 I/O랙과 DSP를 연결하는 통로인 디지털 오디오 프로토콜도 시간 지연의 요소로 함께 계산되어야 한다. MADI, Dante(AES67), AES50, AVB 등의 오디오 프로토콜은 자체의 레이턴시를 가지고 있기 때문이다. 즉, I/O부에 포함되어 있는 ADC, DAC, DDC 뿐 아니라 DSP 부분(컨트롤 서피스 안이나 외부에 구성되어 있을 수 있다.) 사이의 연결에 사용되는 디지털 오디오 프로토콜, 혹은 오디오 네트워크 프로토콜까지 함께 디지털 믹싱 콘솔 시스템으로써의 레이턴시로 파악되는 것이다.

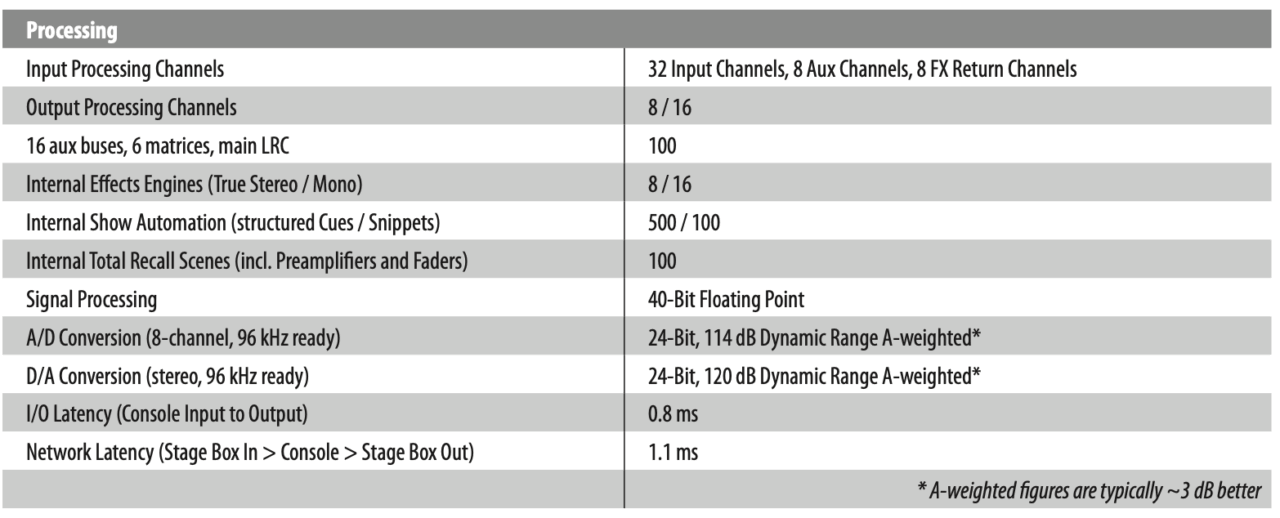

<그림 5>의 Midas M32의 스펙 시트를 보면, I/O 레이턴시 파트는 믹싱 콘솔 자체의 I/O를 사용해 검출된 레이턴시를 표현하고 있다. 아래 항목을 보면 네트워크 레이턴시에는 AES50을 통해 연결된 외부 I/O를 사용해 검출된 1.1ms를 또 표현하고 있다. 즉 외부 I/O와 M32가 사용하고 있는 오디오 네트워크 프로토콜의 레이턴시까지 합쳐진 레이턴시를 표현한다.

2-3. 레이턴시의 발생

앞서 레이턴시를 설명한 부분은 ‘시스템 혹은 하드웨어가 가지고 있는 절대적 지연 시간’을 이야기 했다면, 이번 파트는 곳곳에서 발생할 수 있는 시간 지연을 이야기하고자 한다. 현대의 복잡하고 더 전문적인 오디오 믹스의 형태로 인해 시간 지연 형태가 다양해지고 있다. 레이턴시가 발생할 수 있는 요소가 어떤 것이 있는지 알아보자.

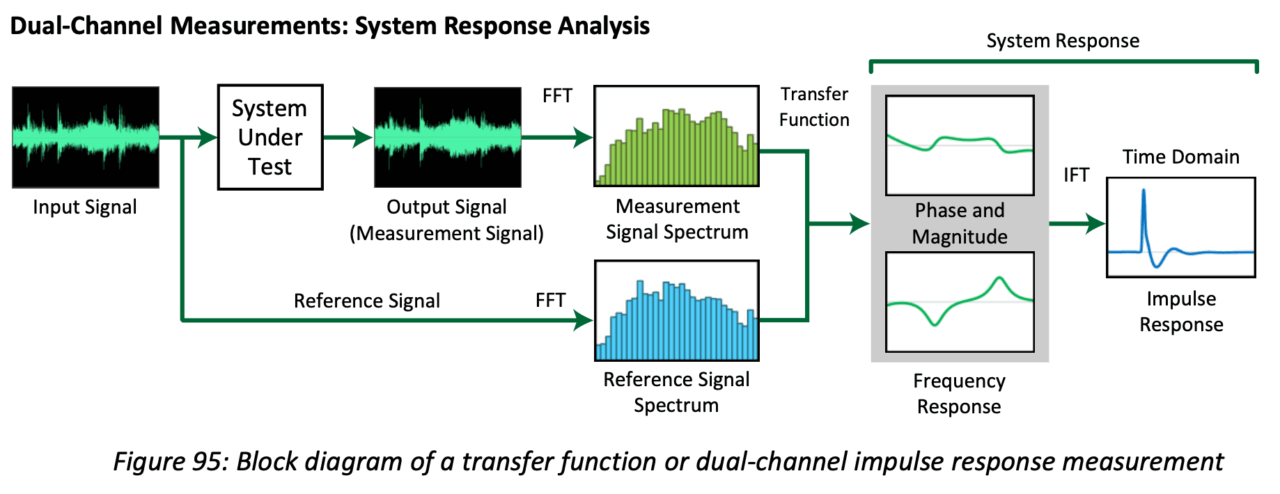

• 레이턴시의 측정 – DUT 측정

필자의 경우, 새로운 음향 기기를 만나면 버릇처럼 Smaart를 사용해 장비의 응답 특성, 레이턴시 등을 확인한다. <그림 6>과 같이 측정 시그널을 믹싱 콘솔 입력한 포트로 넣어주고 채널, 버스 아웃 등을 거친 출력 채널의 시간차와 반응 등을 측정하는 것이다. 흔히 Device Under Test란 이름의 측정법이다. 이를 통해 내가 콘솔이 가지고 있는 I/O를 통해 외부 장비 인서트를 할 때 걸리는 시간, 디지털 오디오 프로토콜을 사용해 인서트한 시간 등도 측정한다. 독자 여러분도 자신의 장비를 측정해, 평소 운용 시 할 수 있는 경우의 수를 다 파악하는데 도움이 될 거라 생각한다. 또 다른 방법으로, 레퍼런스 시그널 측정 채널도 믹서 아웃에 연결해, 래퍼런스 측정 채널 기준 다른 채널의 프로세스에 의한 시간차를 측정 방법도 사용한다.

• 레이턴시 발생 – 신호의 라우팅을 통해

이 부분은 생소한 분들이 있을 수 있다. 콘솔 메이커마다 이 부분이 보정되어 있는 경우도 있기 때문이다. 우선 기본적으로 디지털 믹싱 콘솔은 인풋 채널을 LR 채널로 라우팅하는 이 한 번의 동작에서도 1 sample 정도의 지연이 발생한다. 만약 인풋 채널의 신호를 Group Bus로 라우팅 한다면? 1 sample이 추가된다. 이 지연이 발생하는 포인트를 생각해 보자. 예를 들어, 1번 인풋 채널은 LR 버스로 바로 라우팅하고, 2번 채널은 Group Bus 1개로 라우팅한 다음, 해당 Group Bus가 LR 버스로 라우팅하면 1번과 2번 인풋 채널은 LR 버스로 도착하는 시간이 1 sample 차이가 발생하게 된다. 신호 흐름 자체만으로 이런 채널 간의 시간차가 발생할 수 있다. 이는 예전 필자가 아날로그 콘솔에서 자주 사용하던 테크닉을 디지털 믹싱 콘솔에서 포기하게 했던 이유이기도 하다. 아날로그 믹싱 콘솔 사용 시 필자는 메인 보컬 마이크를 LR 버스에 라우팅하고, 보컬용 버스를 하나 더 만들어 그 버스를 LR 버스로 라우팅해 보컬 마이크 채널만 마스터에서 증가한 테크닉을 사용했었다. 이 테크닉을 한 디지털 콘솔에서 구현하고자 라우팅하는 순간 보컬의 음색과 레벨이 알고 있던 소리가 아니었던 것이었다. LR 버스로 도착하는 메인 보컬 마이크의 시간차가 발생하면서 콤필터링(Comb filtering) 현상이 발생했던 것이다. 필자는 이 이후로 대부분의 디지털 믹서의 라우팅 별 레이턴시를 측정하게 되었다. 또한 믹싱 콘솔 운용 자체를 Group Bus를 사용한다면 모든 채널을 필요한 그룹을 사용해 LR 버스로 SUM되게 한다던가 하는 LR 버스 내지 Matrix 출력에 도착하는 라우팅의 경우의 수를 똑같게 만들어 사용했다.

우리의 믹싱 콘솔의 신호 흐름은 Matrix의 행렬 구조이다. 인풋 채널의 신호를 보내고자 하는 아웃 채널로 보낼 때, Aux 혹은 Flexible하게 값을 가변하게 조절 가능하게 설정하고 선택(라우팅)해 신호를 보낸다거나, Group, Fixed한 형태로 신호를 On/Off 하도록 설정하고 선택(라우팅)해 신호를 보내는 구조이다. 이후 Aux, Group 마스터 채널도 원하는 Bus로 또 라우팅해 신호를 보낼 수도 있고, Matrix 아웃 채널에 Aux, Bus 채널 뿐만 아니라 입력 채널도 신호를 라우팅할 수도 있다. 만약 믹싱 콘솔의 DSP 내부 연산 디자인이나 프로그래밍이 채널의 EQ, Filter, Dynamic을 담당하는 연산과 신호의 흐름을 제어하는 운용을 따로 하는 경우라면 시간차가 발생할 수 있다.

•레이턴시 발생 – 채널 인서트를 통해

가장 많은 부분에서 발생하는 예이다. 채널 자체의 스트립 이외에 콘솔 내부에 있는 FX Rack 혹은 Effect Rack을 사용하는 경우, 신호의 경로 추가로 인해 시간 지연이 발생할 수 있다. 콘솔의 인풋 채널, 아웃 버스, 매트릭스 아웃 등의 원래 채널이 가지고 있는 기본 채널 스트립은 일부러 Delay를 입력하지 않는 한 고정된 시간 시연을 가지고 있다. 하지만 그 이외의 프로세싱을 위해 내부 DSP를 사용해 채널 신호 가운데 인서트 라우팅을 하면 시간 지연이 이루어진다. 최신 디지털 믹싱 콘솔의 트렌드는 유명 아날로그 기기나 디지털 이팩터를 메이커마다 자사의 이름으로 재해석해서 내장화하고 있다. DiGiCo Quantum 시리즈나 YAMAHA DM, PM 시리즈, MIDAS Heritage-D, Behringer Wing, Allen-Heath의 dPack 등의 행보가 예이다. 제조사에 따라 내부 이팩터 랙의 인서트에 따른 시간 지연값은 다르며, 흔히 조금 특별한 이팩터를 사용할 때만 발생하는 건 아니다. 간과했을 수 있는 흔히 사용하는 그래픽 EQ도 채널의 시간 지연을 만들어 낸다. 그래픽 EQ도 DSP 연산의 결과물이다.

믹싱 콘솔 시스템의 물리적인 아날로그 I/O 포트를 사용한다면 ADC, DAC 컨버팅 시간 추가로 인해 시간 지연이 인서트 한 채널에서만 발생할 수 있다. 물론 디지털 I/O를 사용하더라도 샘플 단위 정도의 시간 지연이 발생한다. 이런 부분은 하드웨어 자체의 컨버팅 시간이 추가되어야 하는 부분이기에 절대적인 시간 단위가 적용된다.

물론 플러그인 기반 믹싱 콘솔 시스템도 인서트를 통한 시간 지연은 무조건 발생한다. Avid나 Waves의 디지털 믹싱 콘솔 시스템은 플러그인의 종류, 숫자에 따라 발생하는 시간 지연의 차이가 생긴다.

최근 트렌드 중에 하나인 외부 플러그인 시스템을 사용하는 경우도 생각해 볼 수 있다. 자신의 PC에 인스톨된 VST3 플러그인을 믹싱 콘솔의 연결을 통해서 사용하는 경우다. 이때는 PC 자체의 CPU가 플러그인을 연산하는 DSP 역할을 하게 된다. Native 운용이다. LiveProfessor, Waves SuperRack Performer, YAMAHA VST Rack 같은 경우이다.

이 경우 제일 큰 이슈는 콘솔 밖의 시스템에서 연산이 이루어지기에 콘솔과 연결되는 방법, 연산에 사용하는 플러그인의 종류에 따라 다른 시간 지연값을 보일 수밖에 없다. PC에 연결된 오디오 인터페이스 자체가 가진 레이턴시가 가장 중요하며, 사용하고자 하는 플러그인이 뭔가에 따라 전체 시스템 레이턴시가 결정된다. 외부의 플러그인 DSP를 활용해서 운용하는 플랫폼을 사용하는 예도 있다. 업계에서 가장 많이 사용되는 시스템은 Waves SuperRack SoundGrid 시스템이다. 디지털 콘솔 제조사에 맞는 디지털 오디오 프로토콜을 사용하든지 SoundGrid 옵션 카드를 해당 시스템에 인스톨해 별도의 DSP를 사용하는 구조이다. Waves의 플러그인을 믹싱 콘솔과 함께 활용할 수 있다. 콘솔의 리소스가 아닌 별도의 DSP를 사용하는 장점과 1ms 이내의 플러그인 시스템 구성으로 인해 라이브에서 시간 지연의 유리함을 가지고 있다. 플러그인 기반 콘솔은 AVID의 S6L 시스템도 Waves 플러그인을 사용하려면 SoundGrid 시스템을 구성해야 한다. 지금은 단종된 UAD의 LiveRack 시스템도 아직 현역에 있다.

UAD의 DSP를 내장해 Optic MADI 프로토콜을 사용하는 UAD 플러그인 라이브용 플랫폼이다. 이런 외부 DSP 시스템은 Native 시스템에 비해 짧은 레이턴시를 가지고 있어 전체 믹싱 콘솔 시스템 구성에 유리한 면이 있지만 금액적으로는 상대적으로 고가이다. 이런 시스템도 별도의 DSP를 통해 연산됨으로 시간 지연이 발생하며 아무리 시스템 레이턴시가 짧다 하더라도 결국 믹싱 콘솔 내부에 인서트되면 시간 지연은 필연적이다.

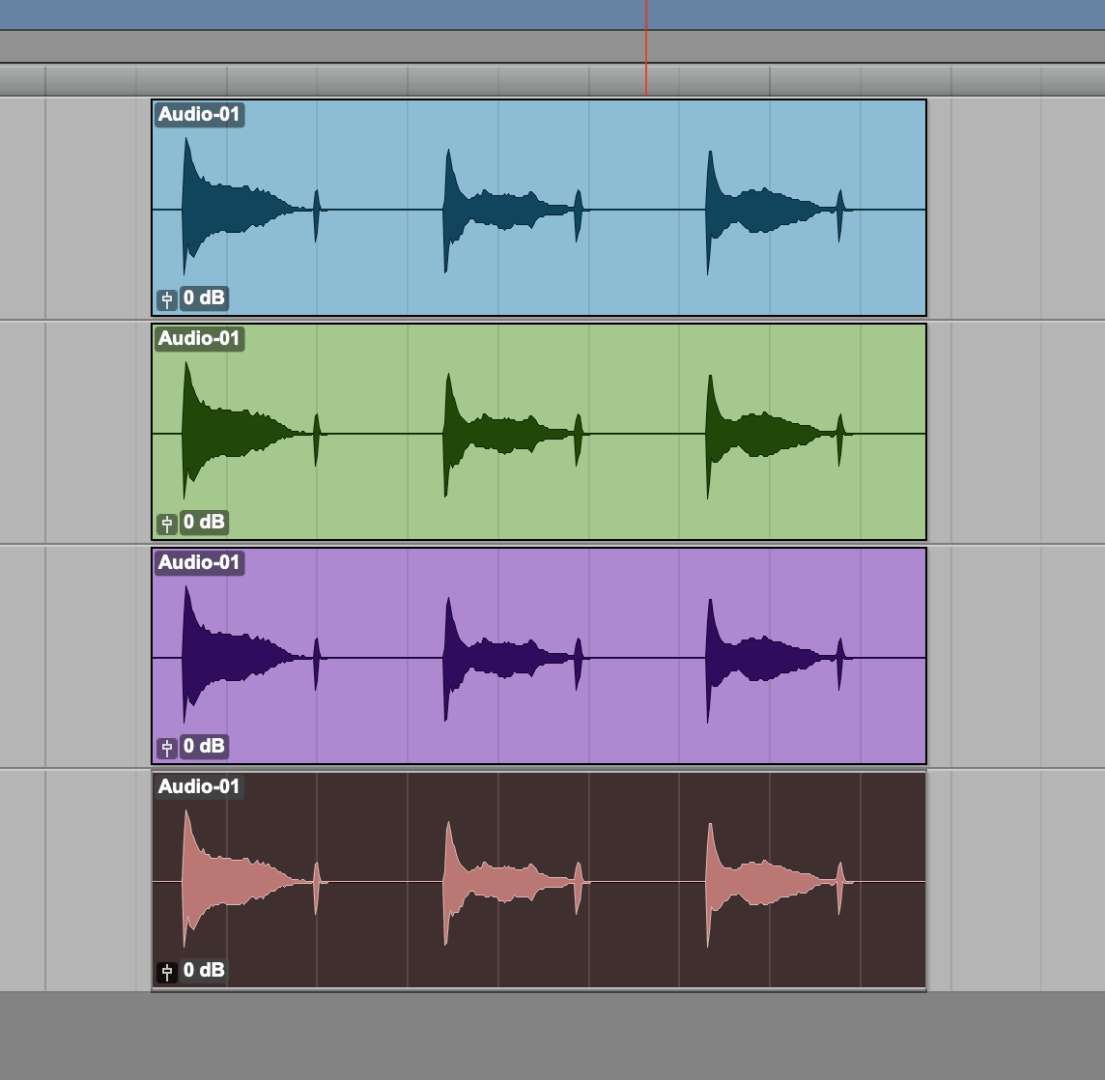

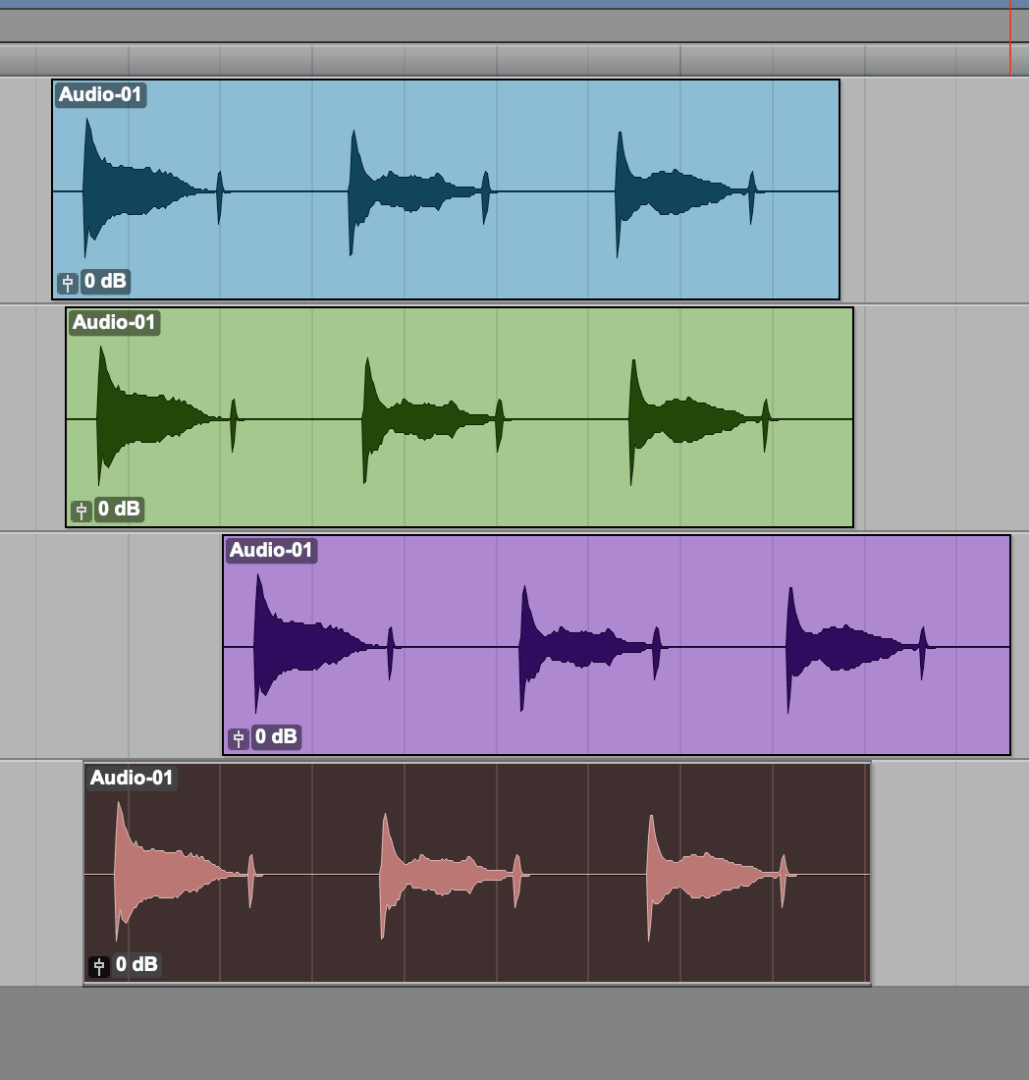

•레이턴시 발생

라이브 상황에서 무대에서 다채널의 오디오를 디지털 믹싱 콘솔로 입력 받는 경우, <그림 8>과 같이 타임라인이 같은 시작축에서 시작하게 된다. 이렇게 같은 시작점, 시간축에 있는 음원은 어느 곳으로 결과물을 보내더라도 믹스 결과물은 운용자가 의도한 결과물로 나오게 믹스가 가능하다.

하지만 앞서 설명한 레이턴시의 발생 원인들을 기억하자. 여러 요인들이 특정 인풋 채널, 아웃 채널에 적용되는 각각 다른 레이턴시는 타임라인 상에서 같은 시작에 있던 음원들을 시간축에서 이곳 저곳으로 흐트려놓는 결과를 얻게 된다. 이런 흐트러진 음원이 하나의 Bus에서 Sum 되면 당연히 시간차로 인한 위상 문제가 발생한다. 콤필터링 효과이다. 무대위의 음원들이 집음되는 환경을 생각해보자. 라인 입력 악기가 아닌 이상, 마이크로 무대위의 음원들이 직, 간접적으로 간섭되어 픽업되며 Sum 되었을 때 위상 문제를 일으키기에 우리는 신경써서 음원에 마이크 셋업을 한다. 그에 반해 믹싱 콘솔의 프로세싱의 이유로 인해 생각하지 않았던 시간차가 발생한다면 더욱 위상의 문제는 커지기 시작한다. 만약 모니터 Mix를 위한 Bus에 시간차가 발생한 음원들이 Sum 된다면, 결과적으로 왜곡된 소리를 제공하게 된다. 시간 지연의 단위가 크다면 타이밍의 문제도 일으킬 뿐만 아니라, 시간차로 인한 불편함을 호소하게 된다.

그래서 최소한 믹싱 콘솔 내부에서 채널별 시간 지연이 발생했을 때, 문제 해결을 위한 장치가 내장되어 있는 것이며, 더욱 적극적인 셋업이 가능하게 트렌드가 바뀌고 있다.

2-4. Delay Compensator에 대해

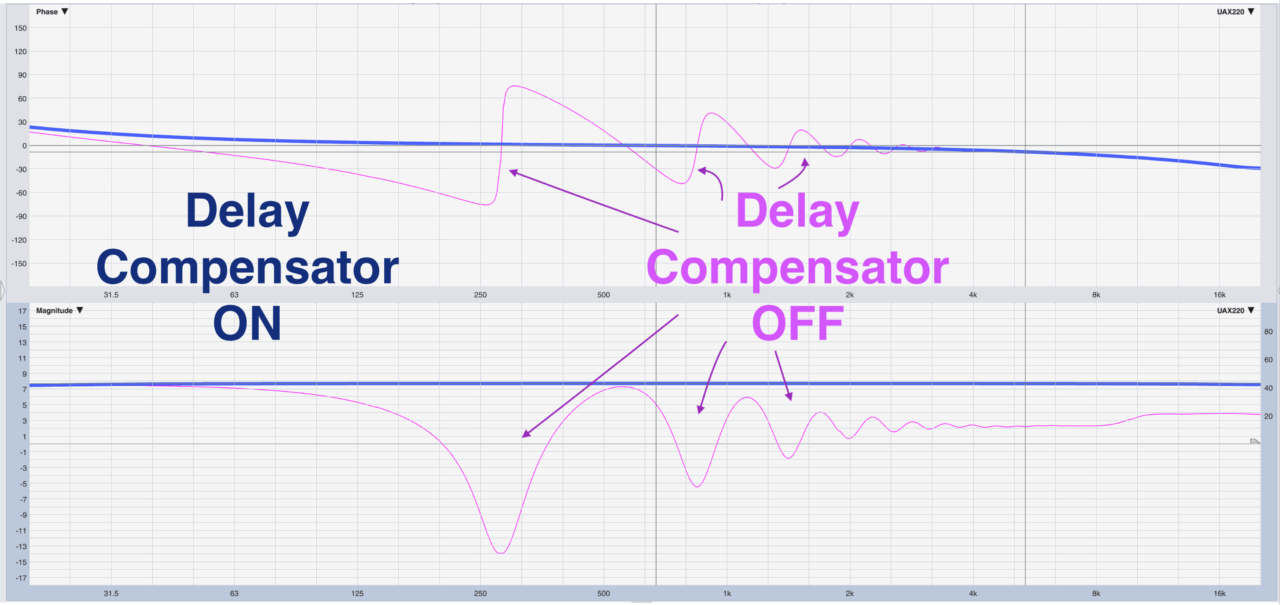

해석 그대로 딜레이를 보정하는 장치를 말한다. 각기 다른 시간 지연이 이루어지는 채널들의 시간을 보정해주기 위해 우리는 Delay Compensator를 사용한다. 다양한 플러그인을 활용하는 DAW 시스템에는 기본적으로 적용되어 있는 시간 지연 보정기는 라이브 환경에서도 다양한 시간차가 발생함에 따라 디지털 믹싱 콘솔에 내장되기 시작했다.

원리는 간단하다. 가장 느린 시간차를 가진 음원 기준으로 상대적으로 빠른 음원들에 그 시간차 만큼 지연시키면 된다. 결과물 기준으로 시작 시간이 아닌 도착 시간 기준으로 시간을 정렬하는 방법이라 할 수 있다. 이 시간의 정렬이 제대로 이루어지면 위상차는 자연히 없어지며 정확한 신호의 합이 이루어지게 된다.

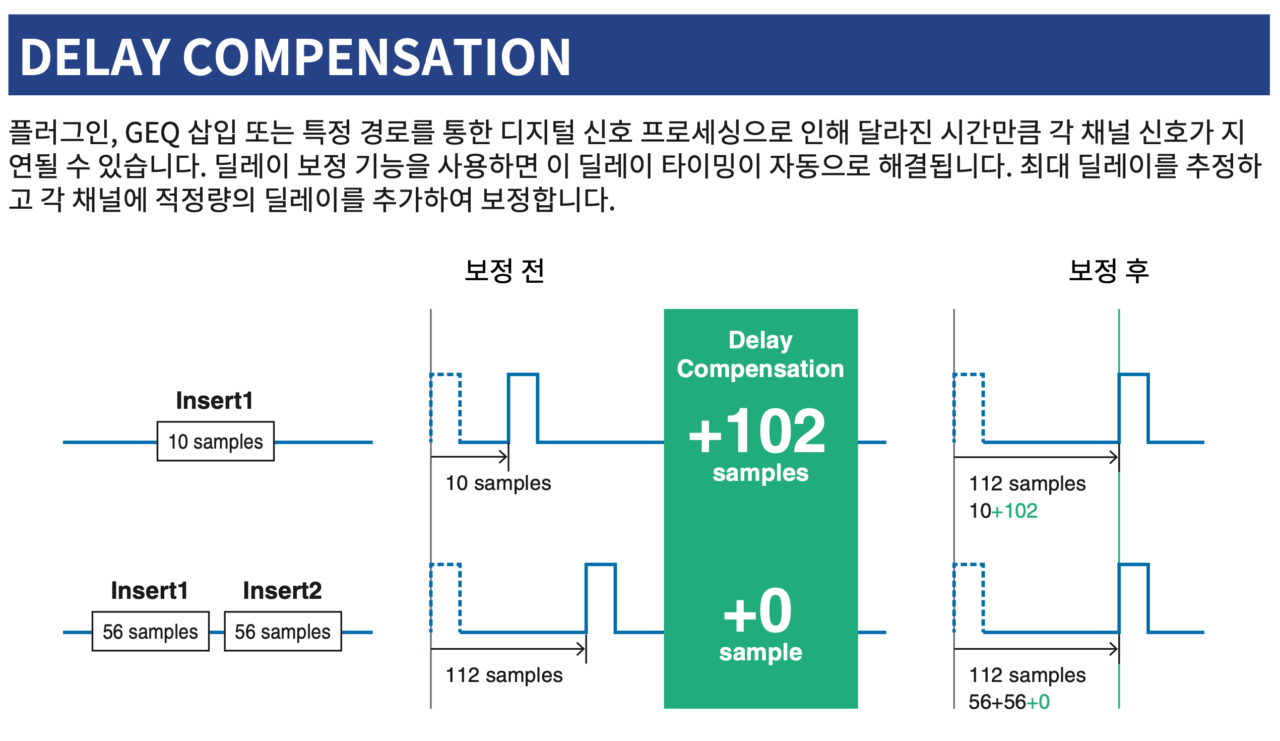

<그림 11>의 Yamaha Rivage PM 시리즈 매뉴얼에 좋은 예가 소개되어 있다. 1번 채널 10 sample의 시간 지연이 이루어지고 있고, 2번 채널은 112 sample의 지연이 이루어지고 있다고 검출했다. 그래서 시간 지연 보정 기능을 사용해서 상대적으로 빠른 1번 채널에 두 지연 시간의 차인 102 sample을 추가 적용해서 같은 시간차를 가진 결과물로 보정한다는 내용이다. 시간을 빠르게 돌리는 것은 타임 머신의 영역이기에 우리는 빠른 녀석을 느리게 만들 수 있다. 한 가지 의문이 들 것이다. 이 시간차가 발생하는 걸 어떻게 시스템이 알고 있는가이다.

디지털 믹싱 콘솔에 내장된 DSP 시스템이 알고 있기 때문이다. 시스템 자체가 가지고 있는 경우의 수를 다 기억하고 있으면 그 기능이 활성화되었을 때, 이 채널은 전체 몇 sample이 지연되었는지 연산이 가능하다. 아날로그 I/O 포트가 가지고 있는 컨버팅에 의한 지연 시간, GEQ로 인한 지연 시간, 특정 플러그인마다의 지연 시간, 라우팅으로 인한 지연 시간 등의 데이터를 기준으로 내부 검출이 가능하다.

만약 외부 DSP를 사용한 채널의 경우는 어떻게 될까? Delay Compensator가 믹싱 콘솔 내부에 내장되어 있더라도 보정은 불가능하다. 데이터가 없기 때문이다. 외부의 시스템이 콘솔 내부에 데이터를 전달해주거나, 외부에서 시간 보정이 이루어져서 같은 시간 축으로 콘솔에 입력되어야 한다. Avid S6L 시스템을 예로 들어보자. 내부의 AAX 카드를 사용해 연산이 이루어지는 플러그인의 경우라면 내부에서 보정이 이루어진다. 하지만 앞서 이야기한 것처럼 S6L에선 Waves 플러그인은 외부 시스템을 이용해야 한다. 이때 채널에 Waves 플러그인을 사용하면 Waves DSP의 보정값이 검출되어 내부 DSP 보정값과 함께 적용된다. 이는 S6L을 위한 전용 Waves 소프트웨어를 사용하기 때문에 가능한 부분이다.

Yamaha, Midas, DiGiCo 등의 제조사 콘솔에서 Waves 플러그인 시스템을 사용한다면 시간 지연 보정은 Waves 시스템 내에서 이루어져야 한다. 시간 지연이 이루어지고 검출하고 있는 DSP는 Waves 시스템이 되는 것이다. PC의 CPU를 사용하는 Native 시스템이라면 플랫폼 프로그램이 돌아가고 있는 시간 지연을 검출하고 적용한다.

정리하면 디지털 믹싱 콘솔의 내부에 Delay Compensator 기능이 내장되어 있다면 콘솔 내부에서 시간 지연의 요소들을 모두 파악해 시간 보정을 한다. 외부에 디지털 오디오 프로토콜을 사용해 오디오를 주고 받는 외부 DSP 시스템의 경우라면 외부에서 시간 보정을 하고, 같은 시간축이 되어진 결과물이 다시 콘솔에 입력되게 한다. 이때의 시스템 전체 레이턴시는 디지털 믹서 자체 In to Out 레이턴시 + 디지털 오디오 프로토콜 레이턴시 + 외부 DSP 연산 레이턴시가 될 것이다.

운용하는 시스템 내에서 sample 단위의 레이턴시 계산을 하는 이유는 48KHz 시스템 운용 시와 96KHz 시스템 운용 시 지연 시간에 차이가 있기 때문이다. 알다시피 운용 샘플 레이트에 따라 지연 시간은 반비례한다. 산술적으로 48KHz에서의 48 sample은 1ms이지만, 96KHz에서의 sample은 0.5ms이기 때문이다. 최근의 디지털 믹싱 콘솔 시스템들이 고해상도의 샘플 레이트 운용을 지향하기에 레이턴시가 자연스럽게 줄어드는 효과도 얻을 수 있다. DSP 기술 발전은 더 많은 연산이 가능하도록 한다. 이는 고해상도 샘플 레이트 운용 뿐만 아니라, 연산량 자체를 늘려서 레이턴시를 줄이는 0 레이턴시 Processing도 가능하게 하는 것이다. DAW 셋업에서 Buffer 셋업을 최소화 해 CPU 연산량을 늘이고 시간 지연을 줄이는 효과를 얻는 것과 같다.

절대적인 시간 지연은 모니터 환경에서 제일 큰 문제를 일으킨다. 사람이 청각적으로 바로 인지할 수 있다. 말하는 사람이 ‘아’ 하고 소리를 내고 모니터 되는 소리가 확연히 느리다면 문제로 충분히 인지할 수 있기 때문이다. 반면 시간축에 모든 소리가 보정된 상황에서 지연이 이루어지고는 있지만 그리 큰 값이 아닌 경우, 문제로 인지하지 않기도 한다. 다만 이 부분도 개인차나 경험치가 존재해 듣는 사람에 따른 기준이 다르기도 하다. 필자는 플러그인 시스템을 운용하더라도 In to Out 레이턴시가 4ms 이하를 유지하도록 운용하는 편이다. 모니터 믹스를 주로 제공하기 때문에 음원이면서 청취자인 나의 클라이언트들이 문제로 인지하는 경우들이 많았기 때문이다. 결국 듣는 사람이 기준이 되어야 하기에 만들어진 필자의 기준이라 보면 된다. 사람에 따라서 8ms 까지는 문제 없다는 경우도 충분히 있기에 여유로운 운용이 가능하기도 하다. 다만 8ms의 시간은 거리로 환산하면 반올림하면 3m 정도 거리가 지연되는 수준이다. 작은 공간의 메인 스피커가 8ms 정도 지연되면 무대 위의 직접음이 먼저 도착하고 다음 스피커 사운드가 관객에게 도착할 수도 있다.

3. Delay Compensator 사용 디지털 콘솔 예

3-1. AVID S6L Ver 7.0 이상

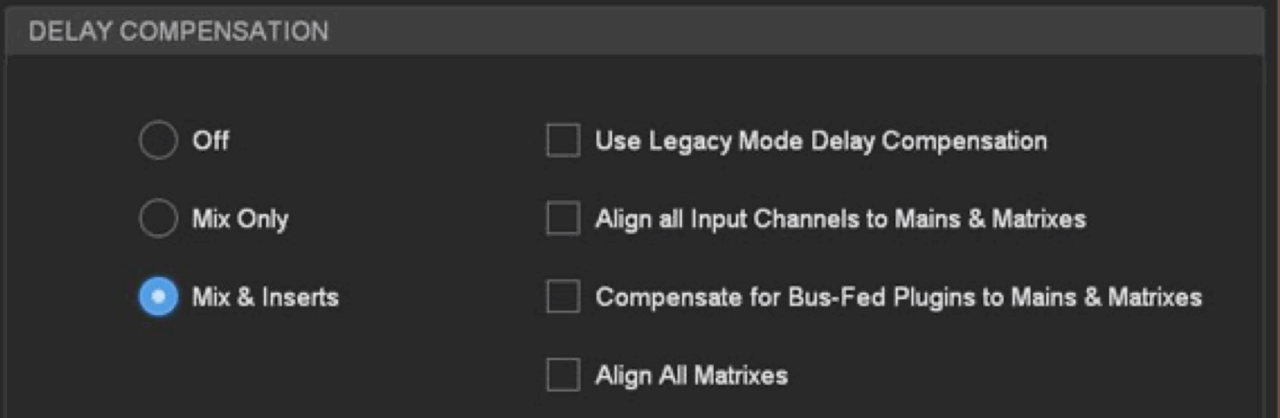

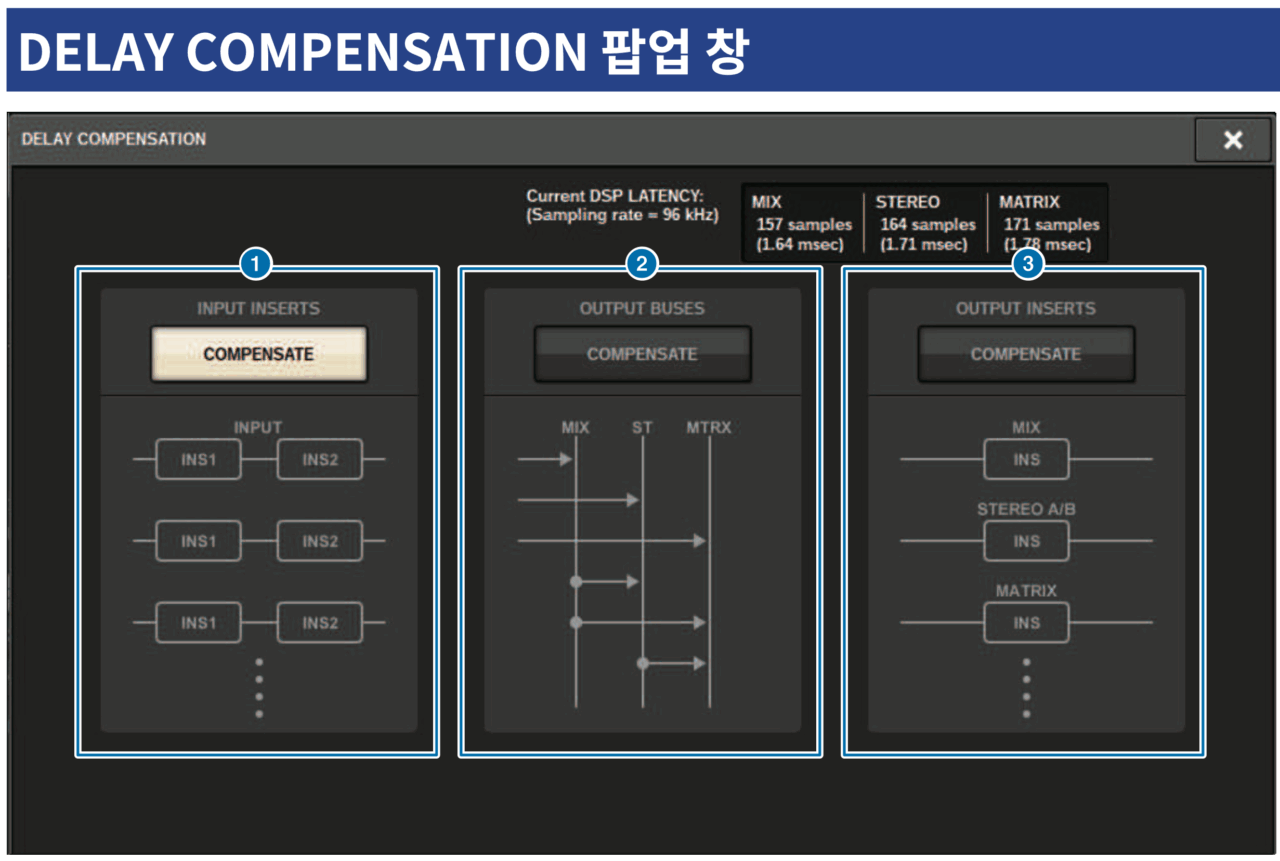

AVID는 플러그인 기반 콘솔 제조사이며 DAW인 Protools 제조사 이기에 Delay Compensator 기능에 적극적인 편이었다. Ver 7.0을 발표하면서 콘솔의 대부분 포인트에서의 시간차를 모두 보정할 수 있도록 디테일하게 기능을 세분화했다. AVID는 채널마다 가지고 있는 시간 지연값을 다 확인이 가능하다.

기본적으로 이전 AVID의 버전들과 같이, Mix Bus로 도착하는 결과물 기준으로 시간 보정하거나, 채널 인서트된 시간차까지 합쳐서 Mix Bus로 도착하는 시간을 보정하는 기능은 기본 내장하고 있다. 물론 필요에 의하면 원하는 채널에서 시간 지연 보정 기능을 끌 수도 있으며 내가 원하는 채널에만 보정기를 켤 수도 있다. 새로 추가된 항목은 LR Main Mix Bus 뿐 아니라, Matrix까지의 도착 시간을 정렬시키는 기능이 있다. 이는 아날로그 믹스에서 주로 사용했던 버스를 사용한 패러럴 믹스 테크닉도 활용할 수 있게 해준다.

또한 다른 인풋 채널 대비, 리버브 FX를 적용할 Aux Send 채널을 FX Rack으로 보내고 FX Rack을 인풋 채널로 다시 return 받아 LR 버스로 라우팅하는 식의 많은 지점의 라우팅도 보정이 가능하다. 특히 S6L은 Matrix 출력을 위한 입력 채널을 개별 선택이 가능한 구조이며, 극성 스위치를 사용해 Mix Minus를 만들 수 있도록 했기 때문에 Matrix 기준의 시간 보정 기능도 적극적으로 하고 있다.

레이턴시가 발생하는 원인들에 모두 시간 지연 보정을 할 수 있도록 포인트를 잡고 있다.

3-2. YAMAHA Rivage PM, DM 시리즈

PM 시리즈의 Compensator 기능은 인풋 채널 인서트 시간차만 보정하는 경우 112 sample이 무조건 자동 적용된다. 48KHz 샘플 레이트 운용 시 2.3ms의 지연이 이루어지며 96KHz 샘플 레이트 운용 시 1.2ms의 지연이 이루어진다. 아웃 채널 인서트 보정의 경우에도 아웃 채널에 112 sample의 지연이 적용된다. 아웃 버스 보정의 경우, MIX 버스, ST 버스, MATRIX 버스로 도착하는 시간의 보정이 이루어지며, 또한 MIX 버스가 ST 버스, Matrix로 보내지는 라우팅으로 인한 지연 시간 보정, ST 버스가 Matrix 보내지는 지연 시간이 보정된다. 만약 모든 시간 지연 보정 기능을 활성화하면 내부에서 48KHz 샘플 레이트 운용 시 7.3ms, 96KHz SR 운용 시 3.6ms 의 지연 시간을 갖는다. 아날로그 포트를 활용한 인서트도 전제로 시간 지연 보정에 산정되어 있어 상대적으로 큰 지연 시간값을 가지고 있는 듯하다.

3-3. MIDAS Heritage-D

Heritage-D는 자사의 아날로그 복각 EQ나 같은 계열사에 있는 T.C. electronic나 Klark-Teknik, Lake Processing 등의 제조사 이팩터, 아웃보드 들을 그대로 FX rack에 집어넣어 가장 적극적인 플러그인 프로세싱 시스템을 내장하고 있다고 볼 수 있는 모델이다. 기본적으로 간단하게 FOH 믹스 모드이냐 Monitor 믹스 모드이냐 정도에 따른 시간 지연 보정 프리셋을 제공하고 사용자가 상황에 맞게 기능을 On/Off 할 수 있다.

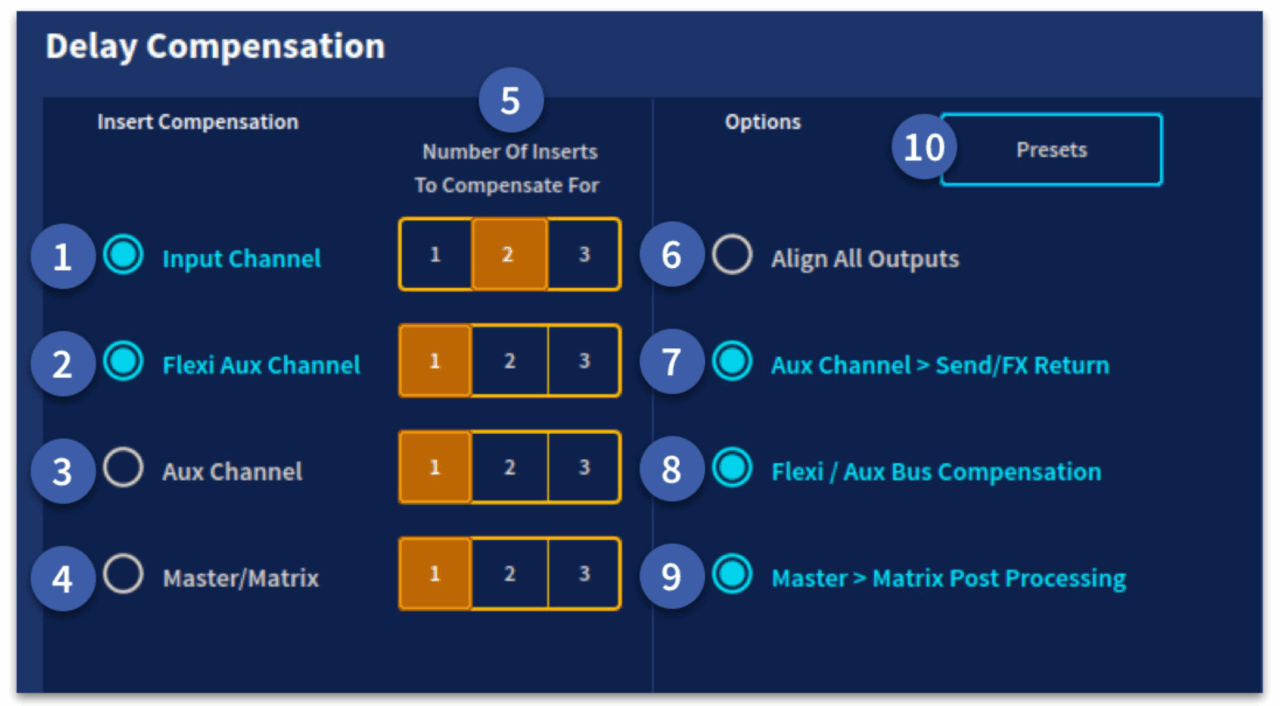

인풋 채널, Flexi Aux 채널, Aux 채널, Master/Matrix 채널에 각각 인서트 갯수에 맞게 보정값을 지정, On/Off 할 수 있다. 또한 각 채널별 보정도 동시에 이루어지며, 각 출력 채널에 도착하는 시간 기준의 보정도 각각 지정할 수 있다. 레이턴시에 민감해질 수밖에 없는 모니터 모드(IEM 믹스를 위한)의 경우 Aux까지의 시간 지연 보정을 하도록 해, 전체적인 시간 지연이 적어지도록 할 수 있고, Matrix까지 정확한 결과물이 만들어져야 하는 경우 최대의 시간 지연 보정이 이루어지도록 하고 있다.

Midas의 다른 모델인 Pro2의 사용자 매뉴얼을 보면 더욱 디테일한 포인트별 Delay Compensation 실제 적용값을 제공하고 있으니 관심있는 분들은 한 번씩 보면 좋을 듯 하다. 기본적인 체계는 같지만 Heritage-D가 DSP 활용 폭이 더욱 크고 경우 수가 훨씬 많다보니 이전처럼 자세한 내용을 아직 밝히기엔 힘들어 보인다.

3-4. Waves emotion LV1

Waves의 플러그인을 기본 사용하도록 만든 플러그인 기반 디지털 믹싱 콘솔 시스템이기에 Delay Compensator는 필수 요소이다. 0.8ms의 내부 DSP 연산 시간에 더해 오디오 I/O의 컨버팅 시간이 포함되어, 48KHz 샘플 레이트 운용 시 2ms 정도의 시스템 레이턴시를 기본으로 플러그인의 레이턴시에 더해지는 시스템이다. 96KHz 샘플 레이트 운용 시 연산 시간은 0.8ms으로 같지만 I/O 컨버팅 시간이 반으로 줄어 1ms 초반의 운용이 가능하다. 플러그인마다 96KHz 기반 플러그인이 있는데, 48KHz에선 존재하는 레이턴시가 96KHz에선 0이 되는 경우도 있다. 상대적으로 짧은 레이턴시의 운용은 96KHz에서 가능하다. 물론 DSP 점유율은 1.5배 정도 상승한다.

모든 인풋, 아웃 채널에서 각 채널의 레이턴시를 검출하고 채널별로 보정 기능을 끌 수도 있다.

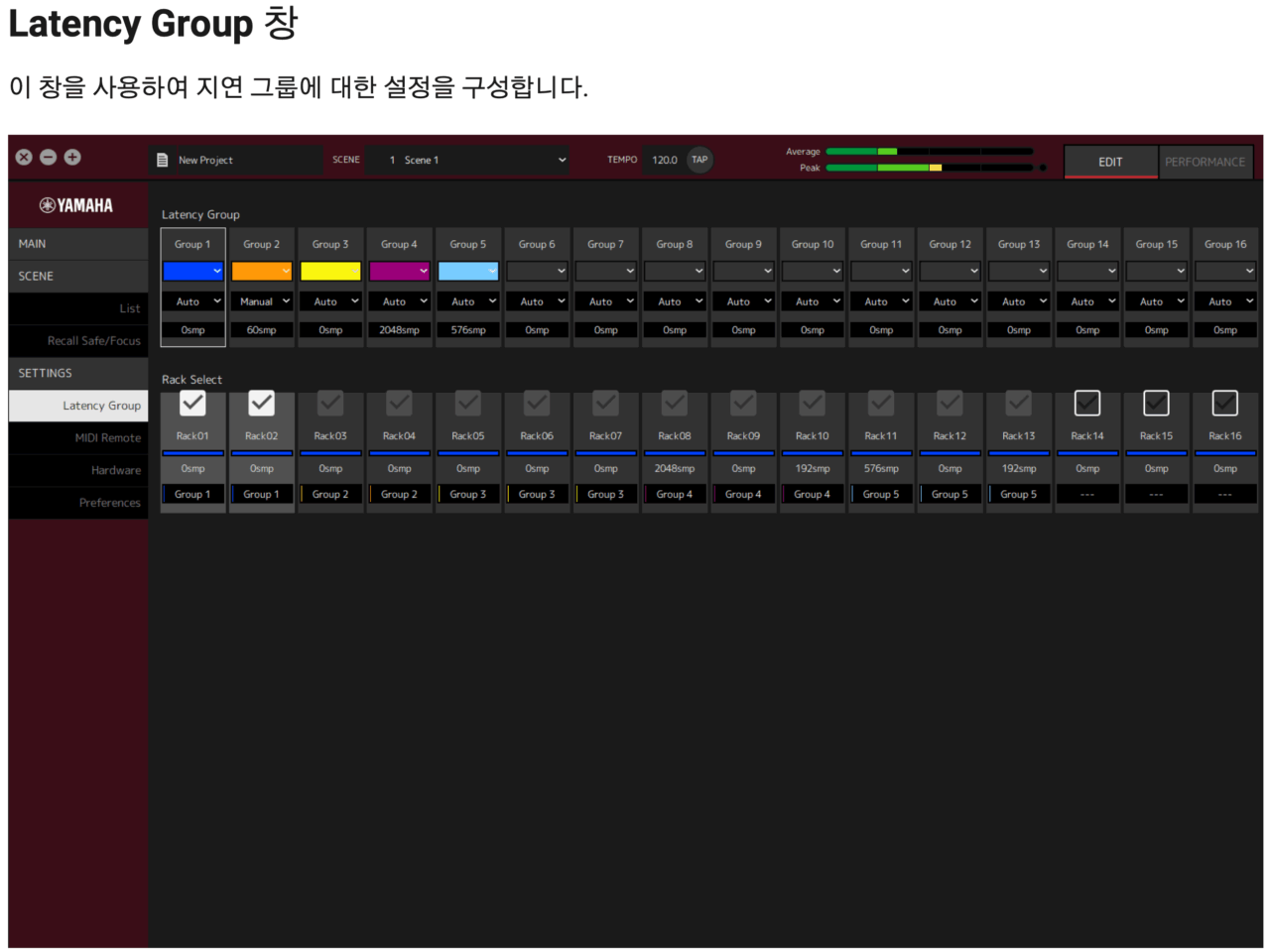

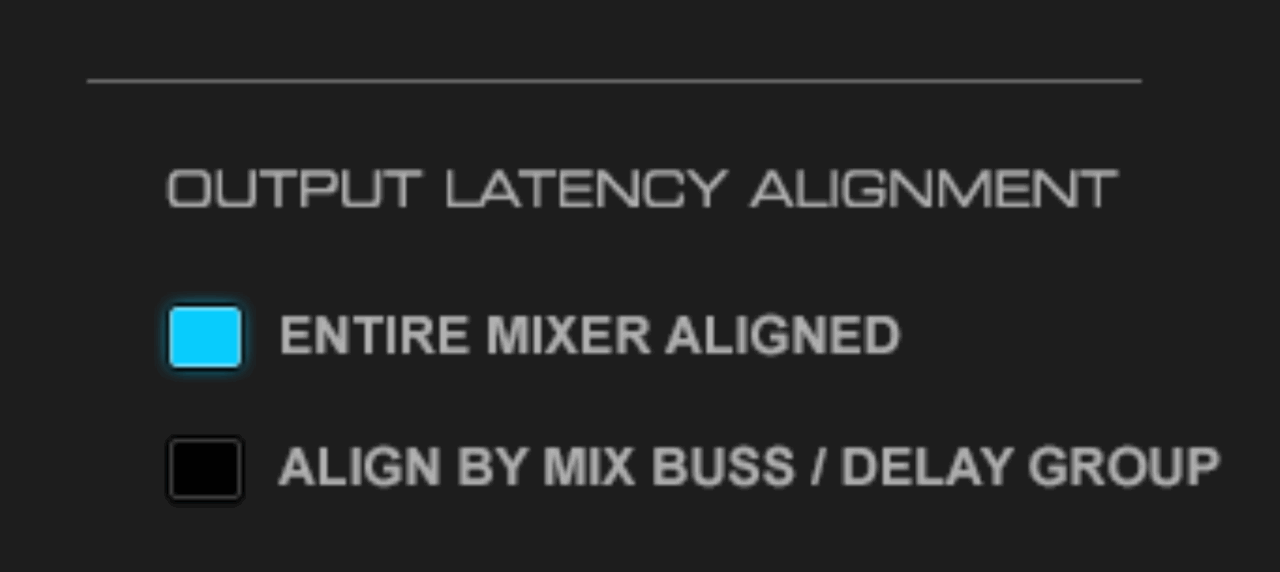

Delay Compensator의 작동 방법은 2가지이다. 기본적으로 모든 출력의 도착에 같은 시간 지연 보정을 입력하게 하는 방법이다. 디테일한 계산 없이 운용해도 안정적으로 모든 출력 채널에 같은 시간의 오디오가 도착하는 장점이 있는 반면에 레이턴시가 긴 플러그인이 적용된 채널이 한 채널이라도 발생하면 시스템 자체의 레이턴시가 지연되는 단점도 있다. 두 번째 보정 방법은 Mix Bus 도착 기준 내지 출력 포트에 도착하는 그룹을 만드는 기준으로 각각 시간 지연 보정이 별도로 이루어지게 하는 방법이 있다. 이 방식은 특별히 Aux, Bus, Master, Matrix의 프로세싱 특성에 맞게 적극적인 프로세싱을 하지만 보정 시간은 유저가 상황에 대처해 운용 가능해 시스템 전체가 시간 지연 보정으로 인해 느려지는 것을 방지할 수 있다. 하지만 결과물마다 라우팅된 인풋 채널의 시간차에 따라 출력되는 시간의 차이는 있을 수 있다는 단점이 있다.

3-5. Delay Compensator가 믹싱 콘솔 내에 내장되어 있지 않은 경우

(믹싱 콘솔 외부의 DSP를 활용하는 경우)

안타깝지만 충분히 그런 디지털 믹싱 콘솔이 이미 많다. 이의 해결을 위해 필자는 DUT 측정을 적극 추천한다. 기본적으로 이런 경우라면 운용 전에 콘솔 운용에 대한 계획을 아주 간단하게 한다. 모든 인풋 채널이 라우팅되는 계통을 통일하게 만드는 것이 최우선이다. 그렇게 함으로써 콘솔 내의 시간차를 동일하게 만들어주는 것이다. 만약 채널 내에서 외부 인서트를 해야 한다면 Group Bus를 우선 2개 준비한다. 첫 Bus는 Delay 된 인풋 채널을 전부 라우팅한다. 두 번째 Bus는 인서트를 사용하지 않은 채널들을 라우팅해준다. 이름은 Align Group이라 칭한다. 이 버스에 DUT를 이용해 측정된 Delay된 채널들이 도착하는 Bus까지의 시간을 측정한다. 이 측정값을 기준으로 시간차를 Align Bus에 delay를 직접 넣어주는 것이다. 결국 두 Bus 사이에 시간차를 줄이고 이 버스들이 LR 마스터 버스로 도착하게 된다면 출력되는 결과물에 대한 시간 지연 보정을 매뉴얼로 하게 되는 효과이다. 다만 이때 문제는 채널 자체에서 Aux로 보내졌던 값은 내가 보정이 힘들다. 모든 인풋 채널의 시간 보정을 하지 않는 한, 모니터 믹스를 제공하는 것보다 FOH 믹스만 하는 경우라면 충분히 유효한 이야기이다. 만약 외부의 DSP를 사용하는 Native 방식이나 DSP 방식의 플러그인 시스템을 활용하는 경우, 이런 운용이 동일하게 사용될 수 있다. 콘솔 기준 외부로 신호가 나갔다 다시 콘솔로 리턴되는 시간차는 플러그인 플랫폼에서 보정이 되었다는 전제라면 한 포인트에서 시간 지연에 대한 보상을 해주면 되는 부분이다. PGM 소스를 주로 만들어야 하는 방송의 경우도 이런 믹스 운용이 충분히 가능하다. 언제나 상황에 따른 판단은 운용자의 몫이다.

4. 결론

지면에 한계가 있어 훨씬 많은 내용을 다루지 못해 아쉽다는 생각이 든다.

디지털 믹싱 콘솔 내에서 여러 프로세싱의 차이로 발생하는 레이턴시의 차이는 위상차를 만들어내고 생각지 못했던 결과물을 만들어낸다는 내용을 다루었다. 크게 생각하지 않았던 채널의 라우팅 과정, GEQ의 적용만으로도 채널별 레이턴시 차이가 발생하기도 하며, 콘솔 내에 있는 FX rack 등을 사용해도 레이턴시가 차이날 수도 있다는 이야기도 나누었다. 그 부분을 적극적으로 해결하기 위해 라이브용 디지털 믹싱 콘솔에는 Delay Compensator가 적용되고 있고, 어떤 제품들이 어떻게 적용하는 예도 들어보았다.

개인적으로 필자가 디지털 믹싱 콘솔을 운용하면서 ‘왜 사운드가 점점 흐려질까?’ ‘내가 생각했던 결과물이 왜 아니지?’란 의문에서 시작했던 이런 이유를 찾아보는 과정은 사소했지만 앞서 설명했던 이유들이 있었으며, 그 해결을 위해 고민하고 기다려왔던 부분이라 이렇게 기회가 되어 나누어 보았다.

앞으로 독자 여러분의 음향 생활이 즐거움이 가득하길 바라며 글을 마친다. ![]()

문 현 민 Omega Media Group 기술총책임자

LOL Champions Korea 음향 총 책임자

넬, 적재, 브로콜리너마저 음향 총감독

![협력사 탐방 #1 [(주)사운드 솔루션]](https://www.stagesoundkorea.com/wp-content/uploads/2025/04/SSM-14-스페셜리포트-사운드솔루션-1-300x200.jpeg)

![공연장 리모델링 사례 [서초문화예술회관]](https://www.stagesoundkorea.com/wp-content/uploads/2025/04/SSM-14-스페셜리포트-서초문예-1-300x200.jpg)